Правильный Robots.txt для WordPress

Дорогие друзья, в этой статье я расскажу вам, как правильно составить Robots.txt для WordPress.

Дорогие друзья, в этой статье я расскажу вам, как правильно составить Robots.txt для WordPress.

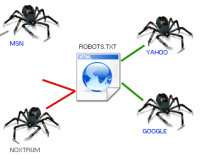

Первое, что вам необходимо сделать, перед тем как добавить блог на индексацию в поисковые системы, вам необходимо составить правильный Robots.txt.

Индексацией блога на движке WordPress можно управлять с помощью файла Robots.txt, расположенного в корне вашего ресурса.

Для автономных блогов этот файл используют для того, чтобы закрыть страницы, содержащие дублированный и ненужный для индексации контент.

Закрыть от индексации, нужно следующие страницы:

— панель администрирования блога, страницы регистрации, авторизации, восстановления паролей;

отдельные страницы комментариев;

— страницы, на которых расположены файлы тем, плагинов, кэширования;

— страницы перенаправления (редиректы);

— страницы трекбеков;

— RSS-фиды;

— поиск по блогу.

Для создания правильного файла robots.txt для WordPress можете использовать приведенный ниже шаблон.

User-agent: *

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: */trackback

Disallow: */comments

Disallow: */comment-page

Disallow: */trackback/

Disallow: */feed

Disallow: *?feed=

Disallow: /?s=

Sitemap: http://ваш-сайт/sitemap.xml

Host: ваш-сайт

Таким образом, файл robots.txt помогает исключить из индекса лишние страницы и управлять индексацией блога на движке WordPress.